Compute

esxtop

haewon83

2023. 4. 5. 11:05

Basic Usage

esxtop 에서 VM만 보려고 할 때는 shift + v

| 10:33:46am up 2 days 4:34, 1013 worlds, 2 VMs, 3 vCPUs; CPU load average: 0.01, 0.01, 0.01 PCPU USED(%): 0.1 0.2 3.9 1.1 0.3 0.3 0.5 0.5 1.1 1.8 1.6 1.6 0.3 23 1.6 0.1 NUMA: 2.4 AVG: 2.4 PCPU UTIL(%): 0.2 0.2 3.9 1.1 0.4 0.4 0.6 0.6 1.5 2.1 1.7 1.7 0.4 14 1.8 0.2 NUMA: 1.9 AVG: 1.9 View VM only ID GID NAME NWLD %USED %RUN %SYS %WAIT %VMWAIT %RDY %IDLE %OVRLP %CSTP %MLMTD %SWPWT 757129 757129 vlcm01 13 2.75 2.83 0.01 1287.81 0.84 0.04 195.11 0.12 0.00 0.00 0.00 34780 34780 vCLS-0d2c5b22-6 8 0.77 0.76 0.00 793.69 2.94 0.01 95.67 0.00 0.00 0.00 0.00 |

특정 World나 VM만 보려고 할 때는, l(소문자 L) 를 누르고 위에서 확인한 GID 값 입력

| 10:35:10am up 2 days 4:36, 1013 worlds, 2 VMs, 3 vCPUs; CPU load average: 0.01, 0.01, 0.01 PCPU USED(%): 0.1 0.2 33 0.5 0.2 0.1 0.3 0.5 0.7 1.3 1.4 1.7 0.1 0.2 2.2 1.5 NUMA: 2.8 AVG: 2.8 PCPU UTIL(%): 0.1 0.3 22 0.6 0.3 0.1 0.4 0.6 1.1 1.6 1.6 1.8 0.2 0.2 3.2 1.9 NUMA: 2.2 AVG: 2.2 Limit display to a single GID (0 to reset): 757129 ID GID NAME NWLD %USED %RUN %SYS %WAIT %VMWAIT %RDY %IDLE %OVRLP %CSTP %MLMTD %SWPWT 757129 757129 vlcm01 13 3.19 3.21 0.02 1288.09 0.00 0.03 201.03 0.03 0.00 0.00 0.00 34780 34780 vCLS-0d2c5b22-6 8 0.45 0.45 0.00 793.90 0.00 0.01 103.01 0.00 0.00 0.00 0.00 GID 값 입력 후 10:35:58am up 2 days 4:37, 1013 worlds, 2 VMs, 3 vCPUs; CPU load average: 0.01, 0.01, 0.01 PCPU USED(%): 0.3 0.2 0.7 0.8 0.2 0.3 0.3 0.5 1.1 1.3 1.3 1.6 0.2 0.2 2.5 1.0 NUMA: 0.8 AVG: 0.8 PCPU UTIL(%): 0.3 0.2 0.8 0.9 0.3 0.4 0.4 0.6 1.4 1.7 1.4 1.6 0.2 0.2 3.1 1.4 NUMA: 0.9 AVG: 0.9 ID GID NAME NWLD %USED %RUN %SYS %WAIT %VMWAIT %RDY %IDLE %OVRLP %CSTP %MLMTD %SWPWT 757129 757129 vlcm01 13 2.80 2.81 0.02 1297.46 0.72 0.03 196.73 0.03 0.00 0.00 0.00 |

기본적으로 VM View에서는 %USED로 정렬

GID로 정렬하려면 shift + n

%RDY로 정렬하려면 shift + r

esxtop 화면에서 보여주는 항목 전환 키

| c – CPU, i – Interrupt, m – Memory, n – Network, d – Disk Adapter, u – Disk Device, v – Disk VM, p – Power Management |

만약 World 목록이 너무 길어서 화면에 모두 표시되지 않는 경우에 숫자 키 패드에서 숫자키 '2'로 내가 보고 싶지 않은 World를 선택한 후, 숫자키 '4'로 제거 가능

CPU Overview

- Timestamp

- Uptime

- 실행 중인 userworld 수

- 실행 중인 VM 수

- 모든 실행 중인 VM에 할당된 vCPU 수

- 평균 CPU load

- PCPU Used(%) : Physical CPU 별 CPU 사용량 ## (unhalted cycles)/Wall Clock Time

- PCPU Util(%) : Physical CPU 별 중단되지 않은(?) CPU cycle의 percentage ## (non-idle state TSC cycles)/Wall Clock Time

- https://blogs.vmware.com/vsphere/2013/01/what-is-the-difference-between-pcpu-used-and-pcpu-utilized.html

- Time Stamp Counter(TSC) : 일정한 속도로 Clock Cycle을 세기 위해 사용되는 64bit register, Clock Frequency에 영향받지 않음

- Unhalted Cycle : 모든 Clock Cycle은 동일하지만, Power Management나 Hyper-Threading에 의해서 Clock Frequency가 변할 수 있는데 Unhalted Cycle의 이 Clock Frequency에 영향을 받기 때문에 Clock Cycle을 세는 속도가 달라질 수 있음

- Wall Clock Time : 실제 World의 경과 시간

- Power Management나 Hyper-Threading를 사용하지 않는다면, PCPU Used(%)와 PCPU Util(%)는 동일

- Power Management가 활성화 되어 있고, Clock Frequency가 더 낮아진 상태에서 CPU가 실행되는 경우에는 unhalted cycle이 TSC cycle보다 적을 수 있고 이로 인하여, PCPU Used가 PCPU Util 보다 적을 수 있음

- 반면에 만약 Turbo Mode가 활성화 되어 있고, CPU가 더 높은 Clock Frequency에서 실행되는 경우에는 PCPU Used가 UCPU Util보다 클 수 있음

- Hyper-Threading을 사용하는 경우에는, 개별 Core가 두 개의 PCPU 소유

- 만약 하나의 PCPU만 busy 한 경우에, PCPU Used는 (unhalted cycles)/Wall Clock Time에 * 0.5로 계산

- 만약 Core 내의 두 개 PCPU가 모두 busy 한 경우에, PCPU Used는 (unhalted cycles)/Wall Clock Time에 * 0.625로 계산 ## 두 Hyper-Thread가 Core 용량의 125%를 활용

- PCPU Util(%)은 PCPU가 얼마나 Busy 했는지를 표현하는 반면에 PCPU Used(%)는 Power Management와 Hyper-Threading으로부터 영향을 받는 기간 동안 얼마만큼의 작업이 완료되었는지를 표현

- PCPU Util(%)은 Planning을 할 때 사용 가능하고, PCPU Used(%)는 Troubleshooting 용도로 사용 가능

| 10:43:26am up 2 days 4:44, 1013 worlds, 2 VMs, 3 vCPUs; CPU load average: 0.01, 0.01, 0.01 PCPU USED(%): 1.8 1.6 0.4 0.2 0.4 0.1 0.7 4.0 0.7 0.7 1.9 2.5 0.3 0.6 0.9 0.1 NUMA: 1.0 AVG: 1.0 PCPU UTIL(%): 1.9 1.7 0.4 0.2 0.4 0.2 0.9 4.2 0.9 0.9 2.5 3.2 0.3 0.6 1.2 0.1 NUMA: 1.2 AVG: 1.2 |

- ID : World ID

- GID : Group ID

- Name : Sched Group의 이름

- NWLD : Group 내 World의 수

- %USED : World에 사용된 Physical CPU 시간의 percentage ## %USED = %RUN + %SYS - %OVRLP

- %RUN : VM이 CPU 자원을 소모한 시간의 percentage ## vCPU가 Scheduling 된 시간

- %SYS : Interrupt나 System 관련 처리를 위해서 World 대신에 System Service에 의해서 사용된 시간의 percentage ## System Service라 하면, Interrupt Handler, Bottom Handler, System World, %SYS 값이 높다는 것은 IO가 많이 발생하고 있다는 의미

- %WAIT : Wait 상태에서 World가 소모한 시간의 percentage

- %IDLE : vCPU World가 Idle loop에 있던 시간의 percentage, %IDLE은 vCPU World에만 적용 따라서 다른 World는 %IDLE이 "0"

- %OVRLP : ??

- %CSTP : SMP VM이 실행되기 위해 기다리는 시간의 양, co-vCPU scheduling contention 때문에 지연이 발생할 수 있음, %CSTP는 여러 PCPU가 사용 가능하도록 기다리는 것을 의미

- %MLMTD : World가 실행되기를 기다리지만, "CPU limit" 설정 때문에 scheduling 되지 않은 상태 ## %MLMTD는 %RDY에 포함

- %SWPWT : ESXi VMKernel이 Memory를 Swapping 하는데 기다리는 시간의 percentage ## %SWPWT는 %WAIT에 포함

- %VMWAIT : ESXi 5.0에서 도입된 Metric으로 World가 event를 기다리는 동안 blocked state에 빠져 있는 시간의 percentage, %WAIT은 I/O wait time과 idle time을 포함하기 때문에 %VMWAIT이 좀 더 세분화된 metric ## %WAIT은 Waiting on Resource, %VMWAIT은 Waiting on Event

- %RDY : VM이 실행되기 위해 기다리는 시간의 양, PCPU에 schedule 되기 위해 queue에서 기다리는 시간 ## CPU Contention 문제 파악 시 확인, %RDY는 전체 vCPU의 누적 값

| ID GID NAME NWLD %USED %RUN %SYS %WAIT %VMWAIT %RDY %IDLE %OVRLP %CSTP %MLMTD %SWPWT 1040 1040 vmsyslogd.10488 7 0.47 0.47 0.00 699.52 - 0.03 0.00 0.00 0.00 0.00 0.00 5794 5794 clomd.1049777 2 0.09 0.09 0.00 200.00 - 0.01 0.00 0.00 0.00 0.00 0.00 27526 27526 vpxa.1052533 39 0.08 0.08 0.00 3900.00 - 0.02 0.00 0.00 0.00 0.00 0.00 22202 22202 rhttpproxy.1051 20 0.04 0.04 0.00 2000.00 - 0.12 0.00 0.00 0.00 0.00 0.00 6138 6138 IORETRY_Ingress 16 0.04 0.04 0.00 1600.00 - 0.02 0.00 0.00 0.00 0.00 0.00 |

Memory Overview

- PMEM/MB : Physical Memory Statistics

- Total : BIOS에 의해서 보고된 System에 설치된 Physical Memory양

- VMK : ESXi VMKernel이 사용하는 Memory

- Other : 나머지 전부

- Free : 여유 Memory

- VMKMEM/MB : VMKernel Statistics

- Managed : VMKernel에 의해서 관리되는 Memory 총량 ## VMKernel Initialization 이후의 Memory 양으로 PMEM 보다 적음, 즉 PMEM이 PMEM 항목에 있는 vmk + other + free 라면 VMKMEM의 Managed는 vmk의 일부 + other + free의 합으로 이해할 수 있음

- Minfree : VMKernel이 여유 공간으로 가지고자 하는 최소 Memory 양

- RSVD : 현재 Reserve 된 Machine Memory 양, 아래 3가지 항목의 합

- VM과 Resource Pool Memory Reservation

- VM의 Memory Overhead Reservation

- Minfree

- URSVD : Unreserved 상태의 전체 Memory 양, 즉 Reservation 가능한 Memory 양

- State : high, soft, hard, low

- State는 Threshold를 정의하고, 이 Threshold는 Host의 Memory 크기에 따라 달라질 수 있음

- 언제 Host Memory를 Ballooning이나 Swapping 기술을 이용하여 Reclaim 할지 결정

- NUMA/MB : NUMA Statistics

- 개별 NUMA Node의 Physical Memory 양

- ( ) 괄호에 들어가 있는 숫자가 개별 NUMA Node의 Free Memory 양

- PSHARE/MB : Page Sharing Statistics

- Shared : Guest Physical Memory에서 공유되고 있는 Memory 양

- Common : 모든 World가 공통적으로 사용하고 있는 Memory 양

- Saving : Page Sharing 때문에 보관되는 Memory 양

- SWAP/MB : Swap Usage Statistics

- Curr : 현재 Swap 사용

- r/s : Disk에서 ESXi System으로 Swap(Read)되는 속도

- w/s : ESXi System에 의해서 Disk로 Swap(Write)되는 속도

- MEMCTL/MB : Memory Balloon Statistics

- Curr : vmmemctl 모듈에 의해서 Reclaim 되고 있는 Physical Memory 양

- Target : ESXi Host가 vmmemctl 모듈을 이용하여, Reclaim 하려고 하는 Physical Memory 양

- Max : ESXi Host가 vmmemctl 모듈을 이용하여, Reclaim 할 수 있는 최대 Physical Memory 양

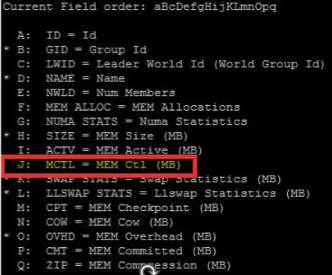

- Ballooning을 확인할 때는 esxtop Column에서 아래 MCTL Field를 추가 필요

- MCTL? : Balloon Driver가 Guest OS에 설치되었는지 유무

- MCTLSZ : Balloon Driver에 의해서 Guest Physical Memory가 Reclaim 된 양

- MCTLTGT : Balloon Driver에 의해서 잡혀있는 Guest Physical Memory 양

- MCTLMAX : Balloon Driver에 의해서 Reclaim 가능한 Guest Physical Memory 최대량

- Memory Limit 값은 VM에 할당된 모든 Memory를 사용하지 못하고 Ballooning 되도록 하는 원인 중 하나 ## MEM ALLOC Field를 추가하면, AMAX Column을 볼 수 있는데 이 값이 -1이면, Memory Limit이 Unlimited 라는 의미

- Memory Swapping이 발생하는 경우 이에 대한 해소 방안으로는 VM의 Power Off/On 밖에 없음

- Memory Swapping의 경우, esxtop에서 SWR/s와 SWW/s Column 확인 필요

| 10:57:36am up 2 days 4:58, 1013 worlds, 2 VMs, 3 vCPUs; MEM overcommit avg: 0.00, 0.00, 0.00 PMEM /MB: 65530 total: 608 vmk,14897 other, 50024 free VMKMEM/MB: 65205 managed: 1266 minfree, 17556 rsvd, 47649 ursvd, high state PSHARE/MB: 43 shared, 43 common: 0 saving SWAP /MB: 0 curr, 0 rclmtgt: 0.00 r/s, 0.00 w/s ZIP /MB: 0 zipped, 0 saved MEMCTL/MB: 0 curr, 0 target, 3939 max |

| GID NAME MEMSZ GRANT CNSM SZTGT TCHD TCHD_W MCTL? MCTLSZ MCTLTGT MCTLMAX SWCUR SWTGT SWR/s SWW/s LLSWR/s LLSWW/s 27754 ad01 16544.95 16081.77 16032.00 16515.07 260.83 20.66 Y 0.00 0.00 10648.97 0.00 0.00 0.00 0.00 0.00 0.00 14850 hostd.2100020 104.09 67.75 73.13 79.91 16.73 11.34 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 1048 vmsyslogd.20976 30.72 15.34 16.29 17.82 9.75 8.81 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 20861 vpxa.2100721 30.60 17.28 22.04 23.76 5.62 0.86 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 1039 vmsyslogd.20976 20.02 11.28 11.73 12.86 11.34 10.89 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 1192 vobd.2097676 18.78 4.71 6.62 7.09 2.01 0.10 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 23419 dcui.2101061 17.63 5.53 6.16 6.71 1.73 1.11 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 8440 hostdCgiServer. 16.90 9.19 10.34 11.25 1.51 0.36 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 24892 hostd-probe.210 16.33 12.86 13.93 15.22 1.54 0.46 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 10958 rhttpproxy.2099 13.73 4.95 8.30 8.79 4.43 1.09 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 31210 esxtop.2102240 13.50 9.18 9.90 10.82 4.44 3.71 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 2362 kmxa.2098404 13.25 7.02 8.58 9.28 1.96 0.40 N 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 |

Storage Device Overview

- DAVG/cmd : command 당 평균 device latency(ms 단위)

- KAVG/cmd : command 당 ESXi VMKernel latency(ms 단위)

- CMDS/s : 초당 생성되는 command 수

- READS/s : 초당 생성되는 Read command 수

- WRITES/s : 초당 생성되는 Write command 수

- MBREAD/s : 초당 Read(Megabytes)

- MBWRTN/s : 초당 Write(Megabytes)

- GAVG/cmd : command 당 Guest OS의 latency(ms 단위) ## GAVG = KAVG + DAVG

- QAVG/cmd : Read operation 당 read queue의 latency(ms 단위)

- Device : Storage Device 이름

- DQLEN : Storage Device의 현재 device queue depth

- WQLEN : World queue depth, World가 수행가능한 ESXi VMKernel의 Active Command 최대 수

- ACTV : 현재 Active Command 수

- QUED : 현재 Queuing된 Command 수 ## 이 값이 높은 경우, Storage System이 Overload 되었다는 의미, 이는 Queue Depth를 늘려서 Storage Bottleneck을 줄여볼 수 있음

- %USD : Active Command에 의한 Queue Depth ## %USD = ACTV / QLEN * 100%

- LOAD : Active Command + Queued Command

| 12:49:54am up 44 min, 1167 worlds, 1 VMs, 8 vCPUs; CPU load average: 0.04, 0.04, 0.03 ADAPTR PATH NPTH CMDS/s READS/s WRITES/s MBREAD/s MBWRTN/s DAVG/cmd KAVG/cmd GAVG/cmd QAVG/cmd vmhba0 - 1 1.33 0.00 1.33 0.00 0.01 0.04 0.01 0.05 0.00 vmhba1 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba2 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba3 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba4 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba64 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba65 - 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 vmhba66 - 4 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 12:51:54am up 46 min, 1167 worlds, 1 VMs, 8 vCPUs; CPU load average: 0.01, 0.02, 0.03 DEVICE PATH/WORLD/PARTITION DQLEN WQLEN ACTV QUED %USD LOAD CMDS/s READS/s WRITES/s MBREAD/s MBWRTN/s DAVG/cmd KAVG/cmd GAVG/cmd QAVG/cmd naa.60060160c0304e00febb2c647aeb3e6f - 128 - 0 0 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 naa.62cea7f077cd4c0027ad6a6d0f65253c - 64 - 0 0 0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 {NFS}ISOs - - - 0 - - - 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 - 12:51:41am up 46 min, 1167 worlds, 1 VMs, 8 vCPUs; CPU load average: 0.01, 0.02, 0.03 GID VMNAME VDEVNAME NVDISK CMDS/s READS/s WRITES/s MBREAD/s MBWRTN/s LAT/rd LAT/wr 27754 ad01 - 1 1.14 0.00 1.14 0.00 0.02 0.000 0.054 |

Power Management Overview

- Power Management는 ESXi가 개별 PCPU에 어떤 P-State를 요청하고 있는지 표현

- PCPU의 %USED와 %UTIL 차이가 큰 경우에는 Power Management에 의해서 발생하는 문제일 수 있음

- https://kb.vmware.com/s/article/1018206

| 1:27:30am up 1:22, 1167 worlds, 1 VMs, 8 vCPUs; CPU load average: 0.02, 0.01, 0.01 Power Usage: 200W, Power Cap: N/A PSTATE MHZ: CPU %USED %UTIL %C0 %C1 0 0.0 0.1 0 100 1 0.0 1.1 1 99 2 0.0 0.0 0 100 3 0.0 0.0 0 100 4 0.0 0.0 0 100 5 0.0 0.0 0 100 6 0.0 0.1 0 100 7 0.0 0.0 0 100 8 0.0 0.0 0 100 9 0.0 0.0 0 100 10 0.1 0.1 0 100 11 0.0 0.0 0 100 12 0.0 0.0 0 100 13 0.0 0.0 0 100 14 0.0 0.0 0 100 15 0.0 0.0 0 100 16 0.0 0.0 0 100 17 0.0 0.0 0 100 18 0.1 0.1 0 100 19 0.0 0.0 0 100 20 0.0 0.0 0 100 21 0.0 0.0 0 100 22 0.0 0.0 0 100 23 0.0 0.0 0 100 24 0.0 0.0 0 100 25 0.0 0.0 0 100 26 0.0 0.0 0 100 27 0.0 0.0 0 100 28 0.0 0.0 0 100 29 0.0 0.0 0 100 30 0.0 0.0 0 100 31 0.0 0.0 0 100 32 0.0 0.0 0 100 33 0.0 0.0 0 100 34 0.0 0.2 0 100 35 0.0 0.0 0 100 36 0.1 0.1 0 100 37 0.0 0.0 0 100 38 0.0 0.0 0 100 39 0.0 0.0 0 100 40 0.1 0.2 0 100 41 92.8 99.8 100 0 ... |

Network Overview

- PORT-ID : Virtual Network Device Port ID

- USED-BY : Virtual Network Device Port User

- TEAM-PNIC : Team Uplink에서 사용되는 physical NIC

- DNAME : Virtual Network Device Name

- PKTTX/s : 초당 전송되는 Packet 량

- MbTX/s : 초당 전송되는 MegaBits

- PKTRX/s : 초당 수신되는 Packet 량

- MbRX/s : 초당 수신되는 MegaBits

- %DRPTX : 전송되는 Packet 중 Drop 비율

- %DRPRX : 수신되는 Packet 중 Drop 비율

| 1:46:43am up 1:41, 1167 worlds, 1 VMs, 8 vCPUs; CPU load average: 0.01, 0.01, 0.01 PORT-ID USED-BY TEAM-PNIC DNAME PKTTX/s MbTX/s PSZTX PKTRX/s MbRX/s PSZRX %DRPTX %DRPRX 67108871 Management n/a vSwitch0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 67108873 Shadow of vmnic0 n/a vSwitch0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 67108875 Shadow of vmnic1 n/a vSwitch0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 67108881 vmk0 vmnic0 vSwitch0 79.81 0.14 226.00 54.60 0.04 85.00 0.00 0.00 67108882 vmk1 vmnic0 vSwitch0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 67108883 2101749:ad01 vmnic0 vSwitch0 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100663308 Management n/a vSwitch1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100663310 Shadow of vmnic2 n/a vSwitch1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 100663312 Shadow of vmnic3 n/a vSwitch1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 2214592520 vmnic0 - vSwitch0 79.81 0.14 226.00 54.60 0.04 85.00 0.00 0.00 2214592522 vmnic1 - vSwitch0 0.00 0.00 0.00 8.40 0.00 62.00 0.00 0.00 2248146957 vmnic2 - vSwitch1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 2248146959 vmnic3 - vSwitch1 0.00 0.00 0.00 0.00 0.00 0.00 0.00 0.00 |

[참고 자료]

ESXTOP Guide

https://www.virten.net/vmware/esxtop/

Interpreting esxtop Statistics

https://communities.vmware.com/docs/DOC-9279

vSphere Monitoring and Performance

https://pubs.vmware.com/vsphere-55/topic/com.vmware.ICbase/PDF/vsphere-esxi-vcenter-server-55-monitoring-performance-guide.pdf

Metrics and Thresholds

http://www.yellow-bricks.com/esxtop/